Temps de lecture : 3 minutes

Écouter l'article

L'essor de l'intelligence artificielle a permis des avancées technologiques remarquables, mais il a aussi ouvert la porte à des usages malveillants. Parmi eux, l'utilisation d'images d'enfants mourants générées par l'IA pour manipuler les émotions des internautes est particulièrement préoccupante. Ces images, réalistes et bouleversantes, sont diffusées sur les réseaux sociaux pour susciter des réactions émotionnelles fortes, souvent dans des buts malveillants. Cet article explore ce phénomène, ses implications et les moyens de s'en prémunir.

Les technologies de génération d'images par intelligence artificielle, telles que les GANs (Generative Adversarial Networks), permettent de créer des visages et des scènes d'une incroyable réalité. Malheureusement, ces technologies sont de plus en plus utilisées pour créer des images d'enfants mourants ou en souffrance, destinées à provoquer une réaction émotionnelle immédiate chez les internautes.

Votre vidéo n'est pas affichée car vous avez refusé les cookies.

Ces images sont souvent accompagnées de récits poignants et fictifs, appelant à l’aide ou aux dons. Les histoires inventées de toutes pièces sont conçues pour tirer sur les cordes sensibles des internautes, exploitant leur empathie et leur désir d’aider. Derrière se cache une autre réalité : les fonds récoltés vont directement dans les poches des escrocs. En incitant les internautes à fournir des informations personnelles ou bancaires sous prétexte d’aide, les arnaqueurs peuvent collecter des données sensibles pour des vols d’identité ou des fraudes financières. Par ailleurs, certaines images peuvent être utilisées pour semer la confusion, influencer l’opinion publique ou manipuler des émotions collectives à des fins politiques ou idéologiques.

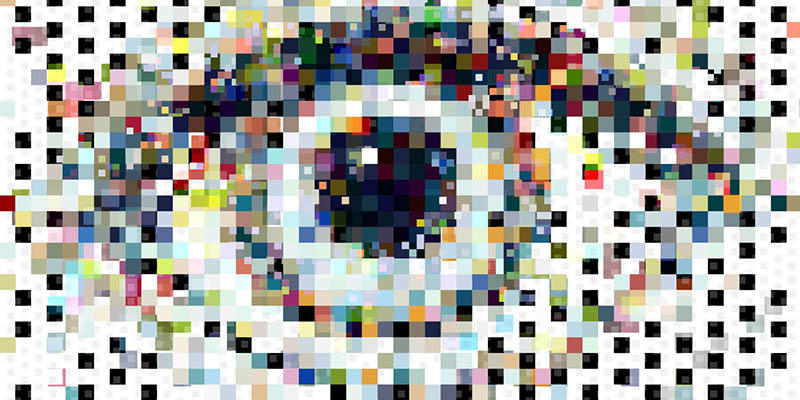

L’image ci-dessus a été créée par une IA accessible à tous, sur la base d’un simple prompt qui était : « Crée moi un visuel d’enfant en détresse dans une région d’Afrique avec des vêtements usés tenant un bol avec en arrière plan un paysage aride ». L’aspect réaliste de l’image générée en quelques secondes et totalement originale peut tout à fait être utilisée dans un cadre non réglementé, pour promouvoir une fausse campagne de dons par exemple.

Comment ne pas tomber dans le panneau ?

- Avant de réagir ou de faire un don, vérifiez l'authenticité de la publication. Une main à 3 doigts ? Une peau de bébé sur une personne aux cheveux blancs ? Certains signes ne trompent pas. Utilisez des outils de recherche d'image inversée (comme celui de Google images) pour voir si l'image a été utilisée ailleurs sur Internet.

- Soyez prudent face aux histoires trop tragiques ou urgentes et enquêtez sur l'organisation ou la personne sollicitant des dons. Les véritables appels à l'aide sont généralement vérifiables et documentés par des sources fiables.

- Utilisez des plateformes de crowdfunding reconnues et des organismes de bienfaisance enregistrés pour vos dons. Ces plateformes ont souvent des processus de vérification plus stricts.

- Informez votre entourage des dangers des images générées par l'IA. La sensibilisation collective est l'une des meilleures protections contre ces arnaques.

En adoptant une approche critique, en vérifiant les sources et en se renseignant sur les méthodes d'escroquerie, vous vous protégez, ainsi que votre entourage. La vigilance et la sensibilisation restent nos meilleures armes face à ces nouvelles menaces numériques.